岩波データサイエンス vol.2 の発刊を記念して、刊行トークイベント「統計的自然言語処理 - ことばを扱う機械」が 3月3日 に開催されました。

- 岩波データサイエンス Vol.2 : 岩波データサイエンス刊行委員会 : 本 : Amazon.co.jp

- トークイベント「統計的自然言語処理ーことばを扱う機械」(岩波データサイエンス Vol.2 刊行記念) - connpass

イベントの様子はニコニコ動画さんで生中継されましたが、その録画は YouTube で公開させてもらっています。

【トークイベント「統計的自然言語処理ーことばを扱う機械」(岩波データサイエンス Vol.2 刊行記念) - YouTube】

自然言語処理に詳しい人でも詳しくない人でもおもしろい本&イベントになったので、ぜひ一度手にとって見てもらえると嬉しいです。

よくわからないけどちょっと味見してみようかなという人には、賀沢さんの招待講演がユーモアたっぷりですので、まずはそれを笑って楽しんでみては。

以上、1ヶ月遅れ(刊行からは2ヶ月遅れ……)の宣伝終わり。

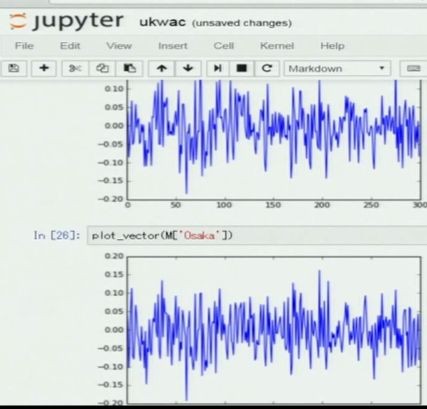

さて、上記イベントで東北大の岡崎先生が、ご発表の冒頭で word2vec で "Tokyo" と "Osaka" のベクトルが似てるという話をしてくださった。

word2vec によって学習した300次元のベクトルそれぞれをplotして、

「結構似てませんか」

「びっくりしたんですけど、視覚で見ても結構似てるなとわかる」

「このくらいの(コサイン)類似度(0.84)だと視覚的に見てもわかるんだな」

とやらかす(失礼)と、会場はドッと受けていたわけだが、実際見た目よく似てる(よね?)。

まあ「見た感じ似てる」とかいうのは主観的過ぎるし、人間の習性的にどうしても「違い」に目が行ってしまうかもしれないが、ピークの位置と大きさはほぼ重なっており、少なくともコサイン類似度が高いことには納得できるのではないだろうか。

そう言われてみて遅まきながら気づいたのだが、高次元でコサイン類似度が大きいというのは、実は「めちゃめちゃ似ている」んじゃあないだろうか。

言語処理っぽいことをしてれば、コサイン類似度をクラスタリングとか判別とかに使うわけで、そのとき 0.6 くらいの値しか出ないと、なんか小さいなあとか思っちゃってたけど、 0.6 くらいでも実は「結構かなり似ている」んじゃあないだろうか。

ランダムな2つのベクトルのコサイン類似度はどういう分布になるのだろう。

まず2次元空間で考える。

2次元球の周囲(つまり円)の上で、とりあえず適当なしきい値としてコサイン類似度が 1/2 以上になるのは、それはあるベクトルの±60度の中にもう1つのベクトルが入る場合である。

よって、コサイン類似度>1/2 となる確率は 1/3 だ。

3次元空間だと、3次元球の表面上を考えて、(cosθ>=1/2な面積) / (球の面積) でその確率は 1/4、と少し減る。

4次元以上の一般の n 次元空間でその確率を求めるには一般の n 次元球の表面積(の一部)を計算する必要がある。

ちょっと考えてみたが、めんどくさい方法しか思いつかなかったので、サンプリングで解かせることにした。

1000000 サンプルのうちコサイン類似度が 1/2 を超える割合を求めると、

- 10 次元 では 0.06 (約 1/17)、

- 20 次元 では 0.01 (約 1/100)、

- 30 次元 では 0.0021 (約 1/480)、

- 40 次元 では 0.00042 (約 1/2400)

と、どんどん少なくなっていき、100 次元 では、1000000個サンプリングした中にコサイン類似度が 1/2 以上になる点はなかった。

こうしてみると、300次元でコサイン類似度が 0.84 とか、もしそれがランダムに取ったベクトルだったなら、宝くじに当たるとか言うレベルの話ではないくらい珍しい現象であることがわかる。

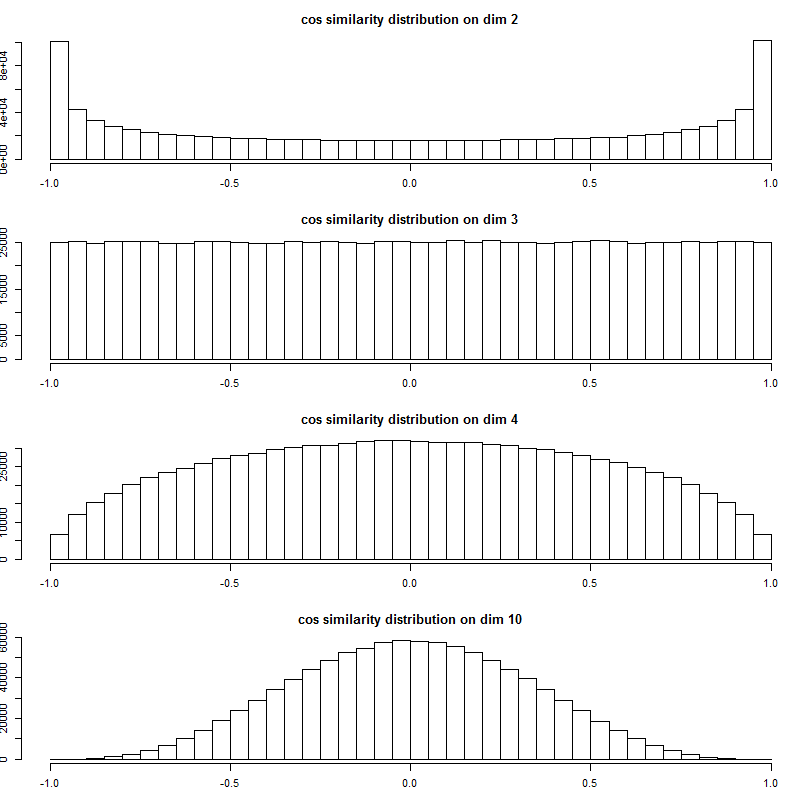

コサイン類似度の分布も見てみよう。

上から 2次元、3次元、4次元、10次元、20次元、30次元、40次元、100次元だ。

2次元ではむしろ ±1 の周辺に多く分布しているのが、高次元になればなるほど、ランダムな2つのベクトルのコサイン類似度は 0 の近辺に大きく偏って集中していくことがよくわかる。

300次元の世界では、適当に取った2つのベクトルはほぼ直交している!

人間は2次元3次元までしか直接的には知覚できないので、どうしても2次元3次元あたりの感覚をそのまま高次元にも当てはめてしまいがちだが(次元の呪いの正体)、この分布を見るとコサイン類似度についてもその感覚が非常に危険であることがよく分かる。

今度からコサイン類似度で 0.6 とかいう値になっても「0.6 しかない」ではなく「0.6 もある!」と思うようにしよう。

- 作者: 岩波データサイエンス刊行委員会

- 出版社/メーカー: 岩波書店

- 発売日: 2016/02/17

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (3件) を見る